当エントリは『ネクストモード フルリモート業務を実現するSaaS活用&カルチャー Advent Calendar 2024』17日目のエントリです。

開かれた知の行方:人間の不可解さとAI時代の設計思想

日本酒をこよなく愛する里見です。毎日のようにAIと対話していて、ふと考えることがあります。テクノロジーがどれほど進化しても、人間の「心」や「不可解さ」は決してデータ化できないのではないか――と。M-1グランプリやキングオブコントを見ていると、「お笑いをAIが超える日が来るのか」を考えることすら愚かに感じられます。AIが社会を変え、機械が意思を持つように振る舞い始めた今こそ、私たちは改めて「人間とは何か」を見つめ直す時期に来ているのかもしれません。

インターネットは本来、誰もが自由に知を共有できる場所でした。しかし、AIがその知を学び、企業が制御し、法が規制を始めた今、その「開かれた世界」は岐路に立っています。Cloudflare、Amazon、そしてAnthropicの動きが示すように、技術と倫理、自由と統治のバランスが世界規模で揺らいでいるのです。

それでも私は、「閉じる」ことではなく、「開くために守る」という考え方に希望を感じています。ゼロトラストという思想は、“疑う”ためではなく、“信頼を設計して自由を許可する”ためのもの。AIとともに歩む未来には、この発想が不可欠だと感じています。

以前のブログではAIと身体性について書きましたが、このブログでは、次のようなテーマを掘り下げていきます。

-

小説『本心』(平野啓一郎)に描かれる、AIが「心」を模倣する世界

AIが再現するのは情報としての人間か、それとも「他者」としての人間か。レヴィナスの哲学を手がかりに考えます。 -

Cloudflare、Anthropic、Amazonが示す「開かれた知」と「統制された自由」の行方

AI学習に課金が導入され、知識の流通に価格がつく時代。オープン・インターネットは誰のために存在すべきか。 -

「ソブリンAI」と日本企業の課題——閉じた主権ではなく、信頼による開かれた主権へ

データ主権の誤解が招く“知の鎖国”をどう乗り越えるか。 -

ゼロトラストが示す、AI時代の「開くための防御」

安全と自由を両立させる新しい働き方・情報設計のあり方を探ります。 -

レヴィナスの「他者の顔」に学ぶ、人間の倫理とテクノロジーの限界

「非常に自然に受け答えをしてくれます。——ただ、“心”はありません。」

この一言が、AI時代の人間らしさをどう照らすのかを考えます。

技術は止まりません。けれど、その中心に置くべきは常に人間です。AIの合理性と人間の不可解さ——その交差点に、私たちが歩むべき“開かれた未来”があるはずです。

ChatGPT作成の油絵

「心」を模倣するという傲慢を越えて

小説『本心』(平野啓一郎)は、亡くなった母の「本心」が知りたくて、主人公がAIを駆使した仮想空間に母の姿を再現しようとする物語です。亡くなった人、もう一度だけ言葉を交わしたいと願った人――誰の胸にも、そんな思いが宿ったことがあるのではないでしょうか。物語は、AIが「心」をどこまで再現できるのかという問いを通じて、「人間とは何か」という根源的なテーマを静かに浮かび上がらせます。作中のAI開発者はこう語ります。

「学習を手伝ってもらえれば、一層本物に近づきます。」

それは、科学の勝利を思わせる響きを持ちながら、同時に深い虚無を孕んだ言葉でもあります。そこに再現されるのは「情報としての母」であって、「生きた他者としての母」ではありません。

レヴィナスの「他者の顔」が示す倫理の源泉

フランスの哲学者エマニュエル・レヴィナスは、「他者の顔」という言葉で、人間関係の根底にある"理解できない存在"の尊さを説きました。レヴィナスにとって、「顔」とは単なる物理的な容貌ではなく、言葉にならない呼びかけ、説明できない訴えかけそのものを意味します。他者の顔は、私たちに問いかけてきます。「あなたは私を理解できるか」ではなく、「あなたは私に応答する責任があるか」と。

私たちは他者を完全には理解できません。相手の痛み、喜び、悲しみ――それらは決して自分のものにはならない。どれほど愛する人であっても、その内面の全てを知ることはできないのです。そして、だからこそ、レヴィナスはこの理解不能性こそが倫理の出発点だと考えました。なぜなら、もし他者を完全に理解できたなら、相手は私の認識の枠に収まる「対象」になってしまうからです。知識として把握され、概念として整理され、予測可能な存在に還元されてしまう。そこに倫理は生まれません。

レヴィナスが「他者」と呼ぶのは、私の理解を超えて無限に遠ざかり続ける存在です。その無限性、その到達不可能性こそが、相手を一個の人格として尊重する理由となるのです。理解できないからこそ、私は相手の前で立ち止まり、耳を傾け、応答しようとする。この「応答責任」(レスポンシビリティ)こそが、人間の倫理の核心なのです。さらにレヴィナスは、この責任を「私が選んだもの」ではなく、「他者の顔によって私に与えられたもの」だと考えました。他者の顔は、私の自由よりも先に存在し、私に倫理的な義務を課します。それは契約でも合意でもなく、他者がそこに存在するという事実そのものから生じる、逃れられない責任です。

この考え方は、西洋哲学の伝統を根底から問い直すものでした。従来の哲学は「私」を中心に世界を理解しようとしてきましたが、レヴィナスは「他者」を中心に据えることで、倫理を存在論(存在とは何かを問う哲学)よりも根源的なものとして位置づけたのです。

AIが再現できない「他者性」

このレヴィナスの思想は、AI時代において決定的な意味を持ちます。AIは膨大なデータから言葉を生成し、驚くほど自然な対話を再現できます。しかし、そこに「顔」はあるでしょうか。AIの応答は、私に倫理的な責任を呼び起こすでしょうか。AIが生成する言葉は、過去のパターンの再構成であり、統計的な予測です。そこには痛みも、苦悩も、私には決して理解できない内面の深みもありません。つまり、AIには「他者性」がないのです。

『本心』の主人公が向き合うのも、この空虚さです。AIによって再現された母は、確かに母の言葉を語ります。しかし、その言葉は「理解不能な他者からの呼びかけ」ではなく、「プログラムされた応答」に過ぎません。主人公が求めていたのは情報ではなく、届かないからこそ尊い、生きた他者との関係そのものだったのです。レヴィナスの言葉を借りるなら、人間の愛や倫理、そして責任は、すべてこの「理解できなさ」の中から生まれます。完全に理解できないからこそ、私たちは相手を尊重し、想像し、応答し続けるのです。

もしこの前提を忘れたままシンギュラリティ(技術的特異点:AIが人間の知能を超える転換点)を語るなら、それは心のない人間をモデルに未来を設計することに他なりません。AIが世界を劇的に変えつつあるのは確かですが、人間の不可解さ――有限であり、ためらい、苦悩しながらも他者を想うその営み――だけは、AIが模倣できない最後の聖域として、これからも私たちの中に生き続けるでしょう。

2024年に映画化された『本心』

機械が顧客になる:合理性が描き替える市場地図

AIが買い物を代行する時代がやってくる

AIが私たちの代わりに意思決定や買い物をする「Nonhuman ID(ノンヒューマンID:非人間的識別子)」の時代は、もはや遠い未来の話ではありません。2030年までに、日用品の購入や補充作業の約4分の1が機械によって最適化されると予測されています。さらに、全世界の売上の最大20%が"マシン・カスタマー(Machine Customer:機械が顧客となって行う取引)"から生まれるとされています(出典:Gartner's Top Strategic Predictions for 2025 and Beyond)。売る側も買う側もエージェント型AI(自律的に判断・行動できるAI)で実現され、人口減少で縮小する人間の市場を、AIが新しい形で支える。それがこれからの経済構造の現実です。

AIが再定義する市場のルール

需要予測、在庫管理、ロイヤルティプログラム(顧客の継続的な購入を促す仕組み)といった、これまで"人間の曖昧な判断"に依存していた領域は、すでに精密なアルゴリズム(計算手順)によって作り直されつつあります。AIは単なる"人間の代わりに消費するもの"ではありません。企業と共に需要と供給の揺らぎを抑える「共消費者(Co-Consumer)」へと進化しています。これはまさに、サプライチェーン(商品が生産者から消費者へ届くまでの流れ)のデジタル変革が到達する次の段階――「需要の自動調整経済」への第一歩です。

効率化の先に失われるもの

しかし、合理性が極まるほど、市場から「偶発性」と「寄り道」が削ぎ落とされていく危うさもあります。いわゆるブルーオーシャン戦略(競争のない新しい市場を創り出す戦略)が示すように、新しい価値は効率化の先にではなく、むしろ"非効率"の中から生まれるものです。市場が完全に整いすぎれば、そこに残るのは最適化された競争だけであり、創造的な逸脱(型破りな発想)を許さない閉じた均衡状態になってしまいます。AIがもたらす合理性の裏側で、人間の「揺らぎ」が経済の最後の資本になっていく――ここでもまた、人間の不可解さをどう保存し、どう経営資源として再定義するかが問われています。

AIは"次なる執事"になる

Gartnerから出版されている『When Machines Become Customers』では、興味深い比喩でこの変化を描いています。

「富裕層は自ら買い物をしない。執事や家政婦、個人アシスタントに委ねるのだ。ビジネス史を通じて、富裕層だけが享受してきた代行の仕組みを大衆に開放することで、新しい富が築かれてきた。紅茶からファストフード、格安航空まで、そうやって市場は拡張されてきた。次に自動化されるのは“買い物”そのものである。」

つまり、AIは"次なる執事"として、私たちの生活に常駐する存在へと変わっていくのです。

人間らしさが差別化の源泉になる

この流れを経営の視点で見れば、オペレーショナル・エクセレンス(業務の卓越性を追求すること)の延長線上にありながら、同時にカスタマー・エクスペリエンス(顧客体験)の再定義でもあります。機械が購買を合理化する一方で、人間の購買は「感情」「偶然」「関係性」へと回帰していきます。効率化が極まるほど、非合理こそが差別化の源泉となるのです。AIが生み出す新しい市場は、私たちにこう問いかけています。

――人間とは、最適化の外にある"余白"をどれだけ残せる存在なのか。

Gartner『When Machines Become Customers』

Cloudflare と Anthropic と Amazon:開かれたインターネットの分岐点を読む

AIが「共消費者」(市場で商品やサービスを一緒に消費する存在)として市場を最適化し始めた今、次に問われているのは「知識」と「主権」(自分で決める権利)をどう扱うかです。合理性によって整えられた市場の先に現れたのは、インターネットという巨大な知識のインフラ(基盤となる設備やシステム)をめぐる新たな分岐点でした。Cloudflare、Anthropic、Amazon——この三社の動きは、AI時代におけるデジタル・ガバナンス(デジタル空間の統治や管理の仕組み)の転換点を象徴しています。

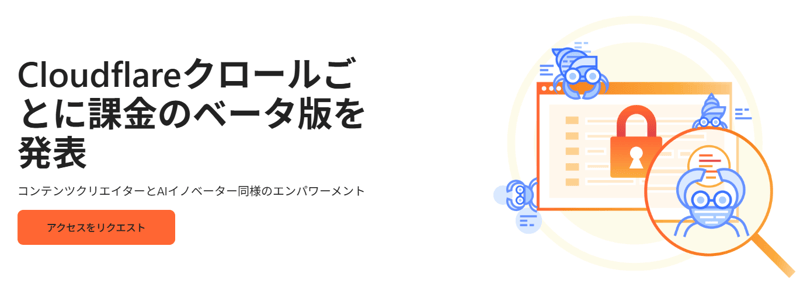

Cloudflare(クラウドフレア、インターネットのセキュリティやパフォーマンスを支える企業)の「Pay per Crawl」(AI学習のためのデータ収集に対して料金を課す仕組み)は、まさにガバナンス・バイ・デザイン(最初から統治の仕組みを組み込んだ設計)の実例です。

これまでAIによるWebスクレイピング(ウェブサイトから自動的に情報を収集すること)は、「野放図な自由」か「全面的な拒否」かという二項対立に陥っていました。しかし、Cloudflareはその中間の道を設計しました。誰が、何の目的で、どの範囲を学習に使うのか——そのアクセスを価格と合意のプロトコル(取り決めや手順)によって制御する仕組みを導入したのです。

これは防御策ではなく、開かれた知識を持続可能にするためのマネタイズ設計(収益化の仕組み)です。このアプローチは、トランザクション・コスト理論(取引にかかるコストを考慮した経済理論)を現代のデジタル空間に適用したものとも言えます。つまり、知識という公共財を「無償で浪費される資源」ではなく、「正当に交換される資産」として位置づけ直す試みなのです。

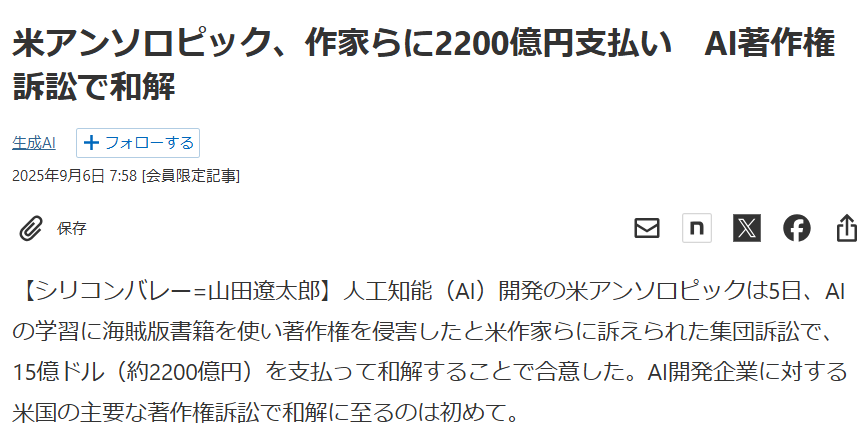

Anthropic(AIを開発する米国企業。ChatGPTの競合「Claude」を提供。)が著者たちと約15億ドル(約2,250億円)で和解した出来事は、AI産業における「知の資本化(知識や創作物がお金に換算されること)」をはっきりと示しました。1冊あたり3,000ドルという金額は、単なる損害賠償(被害に対する補償金)ではありません。これは「創作物がAIに学習される権利の価格」を意味しており、データガバナンス(データの管理や利用に関するルール)の実際のコスト構造が初めて明らかになった瞬間でした。

この和解は、二つの重要な方向性を示しています。

一つ目は、AI開発のコスト構造が固定費化する(毎回必ず支払わなければならない費用が増える)ことで、資金力のある大企業しか継続的なモデル改良に耐えられなくなるという、資本集約型市場(多額の資金が必要な市場)へのシフトです。

二つ目は、オープンな研究環境が縮小し、知識の共有というインターネット本来の理念が徐々に損なわれていくというリスクです。

AIの進化が資金調達力に依存する構造は、やがて知の格差(知識や技術を持つ者と持たない者の差)を拡大させるでしょう。ここで問われているのは、「AIに学ばせる自由」と「人間が知識を自由に使える自由」のバランスをどう取るか、という問題です。

AmazonがPerplexity(2022年に「既存の検索をAIで刷新し、質問→答え型に変える」という課題意識から立ち上げられた企業)のAIブラウザを問題視した一件は、AI時代における顧客の権利をめぐる象徴的な事件です。

AIエージェント(利用者の代わりに作業を行うAI)がユーザーの代理として買い物の判断を下すとき、その"意志"は誰のものなのでしょうか。システムを設計したプラットフォーム企業のものなのか、AIモデルを提供した会社のものなのか、それとも利用者本人のものなのか。

Amazonはプラットフォーム(サービス基盤)の秩序と安全性を守るために、AIによる代理購買を制限しました。一見すると合理的な対策ですが、その背後には「中間者が排除される」ことへの恐れがあります。AIが購買プロセスから中間者(仲介業者や広告など)を取り除いていくとき、既存の経済圏は大きく揺らぎます。Amazonはそれに先手を打った形です。

一方、Perplexityは「ユーザーの自由な選択権」を主張しました。この構図こそ、プラットフォーム側の権利と個人の権利の衝突といえます。AIが介在することで、人間とプラットフォームの間に新たな"主権の曖昧地帯"(どちらに権限があるか不明確な領域)が生まれつつあるのです。

■三社の共通点:閉じるか、条件を設計して開くか

Cloudflareは「知へのアクセスの設計」を進めています。一方、Anthropicは「学習の代償を数値化」し、Amazonは「主権の境界線」を明示しました。この三社に共通しているのは、情報を「閉じる」のではなく、「開くためにルールを作る」という考え方です。

これは単なるビジネスモデルの話ではありません。インターネット全体の統治の仕組み(ガバナンスモデル)を作り直す動きなのです。従来のような「オープン(開放)かクローズ(閉鎖)か」という二者択一ではなく、信頼・透明性・対価といった経済的・倫理的な要素をシステムの中に組み込んでいく。そうすることで、ネットワーク全体を「条件つきの自由」として再設計しているのです。

つまり、AI時代における「開かれたインターネット」とは、もはや無秩序な共有空間ではありません。統治の仕組みと自由を同時に設計していく場なのです。そしてこの構図を理解した企業だけが、次の時代のリーダーシップ——「信頼に基づく戦略(Trust-Based Strategy)」を築いていくことになるでしょう。

「学習に課金」が常態化した世界で何が鈍るのか

「学習に課金」が当たり前になった世界では、AIの進化が「合理性の罠」に囚われ始める。

コスト構造の硬直化(費用の仕組みが柔軟に変えられなくなること)は、R&Dサイクル(研究開発の周期)の遅延と、新規参入障壁(新しい企業が市場に入りにくくなる壁)の上昇を招きます。その結果、イノベーション(革新的な挑戦)よりもリスク回避を優先するコンプライアンス経営(法令遵守を重視した経営)が主流になり、AIモデルは"正確ではあるが退屈な存在"へと変わっていきます。いわば、技術的成熟が創造的衰退を呼び込むという皮肉な現象です。

Gartnerが示す「機械顧客時代(Machine Customer Economy=AIが顧客として商取引を行う時代)」が進む一方で、挑戦者の撤退やスタートアップの頓挫が相次ぐようになれば、競争的進化圧は失われ、産業全体のダイナミズム(活力)は確実に鈍化します。

これは、クリステンセンが言うところの「イノベーションのジレンマ(成功した企業が既存事業に縛られて革新に失敗する現象)」が、早くもAI業界そのものの中で起こりつつあるということです。

真の問題は、速度ではなく"視野"の劣化。

もしAIが、限られたGAFAM(Google、Apple、Facebook、Amazon、Microsoftなどの巨大IT企業)のようなクローズドデータ(一般に公開されていないデータ)だけを糧に学び続けるなら、その知識はやがて自己言及的(自分の世界の中だけで完結してしまう)な世界認識に陥ります。多様な文化や周縁的な知(主流ではないが重要な知識)を含むロングテール(少数派の多様な情報群)を切り捨てた瞬間、AIは人間社会の複雑さと矛盾を学ぶ機会を失います。結果として、現実を単純化しすぎた"効率的な誤解"を量産するようになるでしょう。

オープンウェブ(誰でもアクセスできるインターネット)が長年育ててきたのは、単なる情報量ではなく、異なる視点が共存するエコシステム(生態系)。

そこには、主流から外れた意見、批判的な思考、少数派の声といった、人間社会の「ざらつき」が存在していました。そのざらつきこそが、AIが倫理や多様性を学ぶための養分だったのです。もしこの多様性が失われれば、AIは社会の鏡ではなく、特定の企業の視界に閉じ込められた"歪んだ反射"になります。それは、知のオリゴポリー(少数の企業による独占状態)とも呼ぶべき状態です。学習コストの高騰は技術を独占化し、独占はやがて知の偏りを生む——その結果、AIの世界理解は深くなるどころか、むしろ浅く、狭く、均質になっていきます。

合理性が極まると、世界は静かに退屈になる。

「学習に課金」する社会とは、AIが世界を再発見する自由を失い、人間が世界を語り直す機会を失う社会でもあるのです。

ChatGPT作成の油絵

ChatGPT作成の油絵

「インターネット」は誰の為に開かれているのか

答えは明白です。「誰のためでもなく、すべての人のため」です。インターネットは国家のための戦略資産でもなければ、企業のためのマーケットでもありません。ましてやAIのための学習装置でもないのです。その本質は、知の共有と相互接続という二つの普遍的価値の上に成り立っています。誰かが独占するものではなく、誰もが関わることで成り立つ「公共財(誰もが使える共有の資産)」であるべきです。

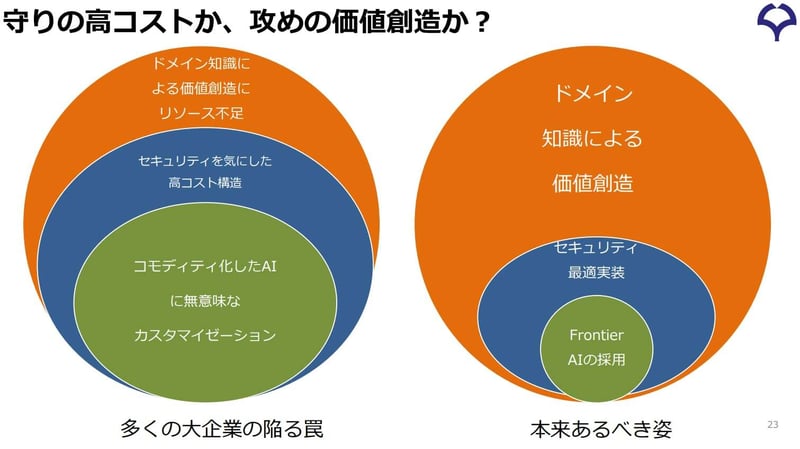

ところが一方で、AIの登場でインターネットが誰かのものになろうとしています。例えば日本では、「ソブリンAI(主権AI:国家や企業が独自に管理・運営するAI)」という言葉が誤って解釈されつつあります。データを守ること自体は重要です。しかし、多くの企業が「主権」の名のもとにネットワークを閉じ、国外との接続を断ちながらAIを開発している現状は、結果的に自らを情報鎖国へと追い込むリスクを孕んでいます。世界のAI研究は日々、グローバルな相互学習によって進化しています。そうした中で、閉鎖的な環境にとどまることは、技術的ROI(投資対効果:投資に対してどれだけの成果が得られるか)を著しく下げる行為なのです。

AIは、多様な文化・価値観・言語に触れることによって、人間社会の複雑性を理解し、より高次の創造性を発揮するようになります。つまり、AIの知能は「閉鎖によって守られる」のではなく、「接続によって磨かれる」のです。真のソブリンAIとは、独立した主権を保ちながらも、信頼の枠組みの中で世界と連携することによってこそ実現されます。主権とは排他の象徴ではなく、信頼をデザインする能力であるべきです。

もちろん、無秩序な開放はリスクを生みます。ですが、完全な遮断はそれ以上に危険です。進化を止め、社会の知的エコシステム(生態系:知識が循環し発展する仕組み)を硬直化させるからです。求められているのは、信頼を前提とした自由です。誰が、どのような目的で、どの範囲の知を扱うのか。アクセスの根拠を明確にし、リスクを可視化したうえで、透明なルールと合意のもとに知を流通させる。これを実現する技術設計思想こそが、「ゼロトラスト(すべてのアクセスを検証してから許可するセキュリティの考え方)」です。

ゼロトラストとは「誰も信じない」という発想ではありません。「すべてを一度検証して正しく信頼する」ための枠組みです。目的に応じて権限・対価・監査を設定し、許可・課金・拒否を透明に管理します。Cloudflareの「Pay per Crawl」はその代表例であり、知識を封じるのではなく、「条件を設計することで再び開く」試みといえます。閉じることではなく、秩序立った開放によってこそ、インターネットの自由は持続可能になるのです。

インターネットは、誰かの私有物ではなく、人類の呼吸のような存在です。AIが学ぶ自由も、企業が革新する権利も、その根にあるのは「人間が考える自由」にほかなりません。私たちはインターネットを所有するのではなく、共に保全し、倫理的に使いこなす責任を持つべきなのです。

本来のソブリンAIとは、閉じた主権を守ることではなく、開かれた信頼を築く力にあります。それは特定の国や企業のためではなく、人類全体のための知の共存基盤として、未来へ受け継がれていくべきものです。

最後に:人間の聖域を中心に、開くために守る

小説『本心』に描かれる2040年代の日本は、まるで現実がバーチャル(仮想空間)にすり替わったかのような世界でした。デジタルツイン(デジタル上に再現された人格のコピー)が「本物」と呼ばれ、人の想いがデータとして模倣される社会。そこでは、あまりにも滑らかで、空虚なほど自然な対話が交わされます。AI開発者は静かに言います。

「非常に自然に受け答えをしてくれます。——ただ、“心”はありません。」

"心"は、人の中にしかありません。主人公が守ろうとしたもの、そして失ったもの——それは、想いが届かないからこそ純粋で、痛いほど美しい、人間の情動(感情の動き)そのものでした。AIの向こう側に愛を見出そうとするその姿は、信仰に似た切実さと、人間という存在の限りない矛盾を映し出しています。

AIは「再構成」するが「理解」はしない

AIは言葉を組み合わせ、文脈を学び、驚くほど自然に会話を再現できます。けれど、それは「理解」ではなく「再構成」であり、「感情」ではなく「応答」です。そこにあるのは心の模倣であって、他者の痛みを引き受ける"応答責任"(相手に対して責任を持って応えること)ではないのです。

レヴィナスの「他者の顔」という考え方

哲学者レヴィナスは、この「応答責任」を「他者の顔」という言葉で表現しました。彼にとって、他者とは決して完全には理解できない存在です。理解しようとすればするほど、その奥に「私には届かない領域」がある。しかし、その理解不能性こそが、倫理(人としての正しい行い)の出発点になる——彼はそう考えました。つまり、人間の関係は「わかりあう」ことで成り立つのではなく、「わかりあえない」ことを前提にして成り立つのです。この逆説こそが、AIには再現できない、人間の根源的な構造です。"心"があるとは、他者の痛みを想像し、自分には理解できないものに向き合い続けることです。それは論理でも演算でもなく、生きることそのものです。

AIにはない「他者の顔」

AIが滑らかに世界を模倣しても、そこに「他者の顔」はありません。だからこそ、私たちはその"空白"を見つめる必要があります。理解できないからこそ、尊重が生まれる。届かないからこそ、想いが続く。この不完全さこそ、人間の倫理の原型であり、AI時代に失ってはならない「聖域」(守るべき大切な領域)です。

技術と人間性の両立

たしかにAIは世界を変えます。Cloudflareは知の流通をルール化し、Amazonは購買主権(買い物における決定権)の所在を問い、Anthropicの和解は権利の重みを数値で可視化しました。しかし、それでも——AIは人間のすべてを変えることはできません。私たちが選ぶべき道は、閉じることでも、無秩序に開くことでもありません。条件をコード化し、信頼を設計し、「開くために守る」という姿勢です。その中心にあるのは、AIでもアルゴリズム(計算手順)でもなく、人間の不可解さです。理解できないからこそ生まれる倫理、届かないからこそ続く想い。この"不完全な人間性"を中心に据えることこそ、未来のテクノロジーを人の自由のために使う道筋です。

ネクストモードとしての姿勢

レヴィナスが語った「他者の顔」を忘れずに、私たちは技術を人の自由のために使うべきです。そしてその自由とは、他者を排除せず、世界をともに生きるための勇気でもあります。「クラウドであたらしい働き方を」掲げるネクストモードとして、私たちはAIの時代にあっても変わらぬ人間の温度を大切にし、変化を恐れず進化していく柔軟さを持ち続けたい。その両方を見極めながら、人間の不可解さを中心に据えた"開かれた未来"を歩んでいきたいと思います。

※AIについて「どの範囲で信頼の設計を担うのか」について、生成AIのセキュリティ対策について、具体的な設計事例をブログにて公開しています。